Moderar la realidad

Por: Carolina Botero Cabrera

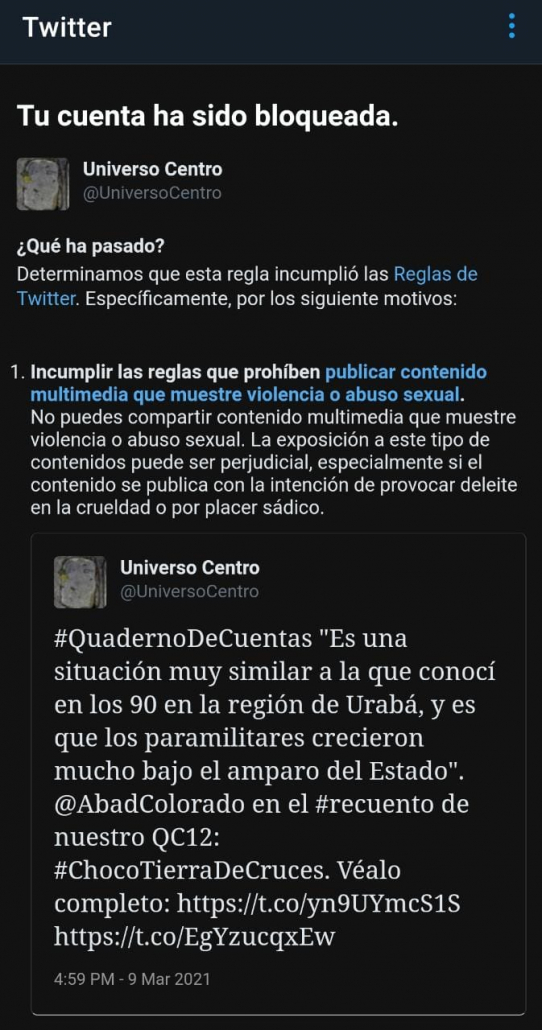

El 7 de marzo el medio digital Universo Centro transmitió una charla en vivo, los primeros 15 minutos eran un audio del reportero y fotógrafo Jesús Abad Colorado sobre la situación de violencia en Chocó. Dos días después bloquearon su cuenta de Twitter @UniversoCentro, porque un trino que referenciaba ese audio incumplía las normas de comunidad al “publicar contenido multimedia que muestre violencia o abuso sexual”. El contenido violento es un problema en redes sociales, pero es una moneda de dos caras. Aunque hay un contexto que explica la acción de Twitter, no deja de ser problemático y además evidencia que carecen de un buen proceso de apelación y corrección de errores.

En 2017 durante un evento internacional de IFEX, red de organizaciones de libertad de expresión, escuché a un activista sirio exiliado contando que la inteligencia artificial de moderación de contenidos de YouTube borraba —sin intención, pero efectivamente— el archivo ciudadano de los crímenes de guerra en su país. Su trabajo ahora consistía en salvar lo que quedaba pasándolo a servidores donde no aplicaran las normas de comunidad que, intentando combatir el terrorismo y la violencia, desaparecían los contenidos que denunciaban esos hechos.

Ese año los medios comenzaron a reportar esto y, desafortunadamente, entiendo que continúa, a tal punto que en 2020 se dijo que afecta el trabajo sobre Siria de tribunales internacionales como la Corte Penal Internacional. Desde entonces me he preguntado si en Colombia también se impacta la memoria digital de un conflicto armado en el que las disputas por el territorio llevan décadas y contando.

Las redes sociales son usadas por muchas personas para divulgar y denunciar violaciones a los derechos humanos, y también por criminales para hacer apología a la violencia y promover el disfrute sádico de la crueldad y el dolor. En marzo de 2019 dos masacres en mezquitas de Christchurch (Nueva Zelanda) fueron emitidas en vivo a través de redes sociales y se volvieron virales rápidamente, sobre todo entre quienes se regocijaban viéndolas. La transmisión se anunció previamente y se hizo con una cámara de video en la cabeza del asesino que además publicó un manifiesto cargado de odio y amenazas contra la comunidad musulmana.

Esto tan aberrante disparó las preocupaciones sobre el rol de las redes sociales y motivó un llamado a combatir “el contenido terrorista y violento” conocido como Christchurch Call, que firmaron primero 18 gobiernos y ocho empresas de internet, después lo ratificaron decenas de países, entre ellos Colombia. Afortunadamente, los compromisos no son vinculantes. Pronto se estableció que del afán tales compromisos son ambiguos, difíciles de cumplir sin provocar riesgos importantes —especialmente para la libertad de expresión— y que, al no incluir suficiente discusión ni amplia participación, no pudieron anticipar efectos indeseados. Este documento apunta a que las plataformas usen cada vez más tecnologías de inteligencia artificial para detectar y bloquear ciertos contenidos, y promueve también que lo hagan de forma expedita.

El bloqueo del trino que referenciaba un relato violento de Abad Colorado puede explicarse a la luz de estos antecedentes. Recuerden que hace poco él mismo sufrió el bloqueo de su cuenta por publicar unas fotos explícitas de los horrores de nuestra guerra interna. Después de patalear y con el apoyo de muchas personas, la recuperó.

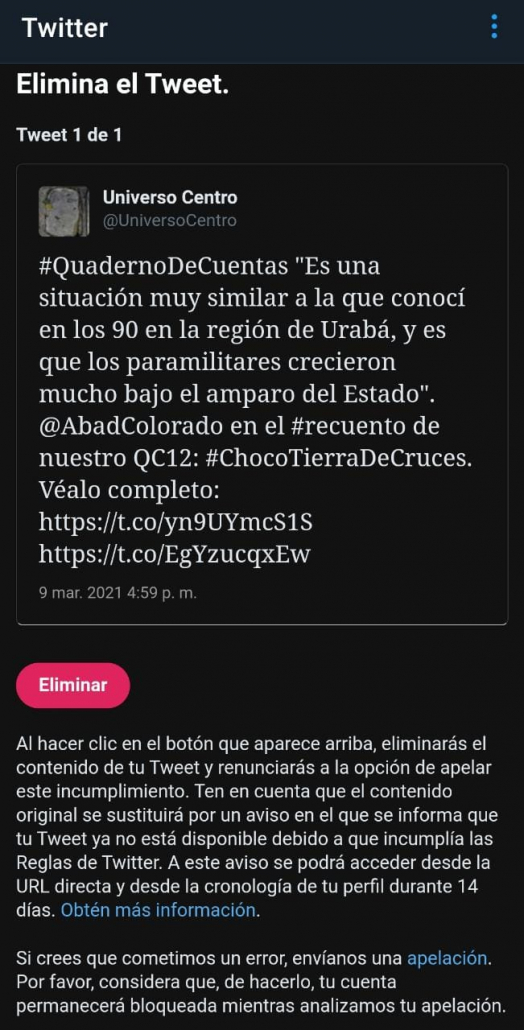

En todo caso, lo que no se justifica en el caso de @UniversoCentro es que Twitter no corrigiera el error. Aunque muchas personas y organizaciones también advertimos a la plataforma y Universo Centro apeló, Twitter no respondió. Al final, para recuperar la cuenta terminaron retirando el siguiente trino: “Es una situación muy similar a la que conocí en los 90 en la región de Urabá, y es que los paramilitares crecieron mucho bajo el amparo del Estado”, @AbadColorado en el recuento de nuestro QC12 #ChocóTierraDeCruces. Véalo completo (enlace al streaming).

En 2017 Karisma, donde trabajo, publicó su informe “Internet es tu pasión”, enfocado en la moderación de contenidos en temas de derecho de autor, pero que sirve para entender, en general, los retos de la moderación de contenidos por estas plataformas. En este informe los casos estudiados indican que “no hay por parte de la ISP (plataforma) ningún mecanismo de seguimiento a las contranotificaciones (apelación) realizadas”.

Es que ni siquiera tienen sistemas de “tickets” o mecanismos para saber qué pasa con un reclamo. Me refiero a algo como lo que tienen empresas transportadoras de paquetes donde se sigue paso a paso lo que pasa con lo enviado. Con demasiada frecuencia estas apelaciones no son atendidas, aumentando el problema. Sin poder seguir la apelación, el silencio, la incertidumbre sobre la posible respuesta y la necesidad de resolver el problema desincentivan mantener el reclamo, con todo lo que eso significa.

Por ejemplo, a pesar de la convicción de que ese trino no violaba las normas de comunidad, quienes están detrás de Universo Centro —para recuperar su voz en Twitter— debieron sacrificar un contenido legítimo e importante para el debate público porque su reclamo fue ignorado. En adelante seguramente se lo pensarán dos veces antes de publicar contenidos de este mismo tipo.

El tema de moderación de contenidos tiene muchas aristas, pero casos como este demuestran no solo que regular la moderación no es fácil —que no se puede generalizar y moderar solo por la naturaleza del contenido, por ejemplo—, también hablan de lo difícil que es implementar estos procesos —no se puede confiar solo en filtros automatizados—, pero además evidencian que las plataformas deben trabajar en los mecanismos de respuesta.

Esto último es por ahora lo más fácil de corregir. Las plataformas pueden apostar por la transparencia en sus procesos de moderación de contenidos. Pueden dar más información, crear sistemas de seguimiento a los procesos de apelación que nos permitan entender las decisiones y que podamos reclamar si las apelaciones no son atendidas, ayudando a las plataformas a ver errores. Es decir, como sugería el informe que les conté, deben “trabajar en mejorar sus procesos de apelación para garantizar que los contenidos que han eliminado erróneamente pueden ser restaurados fácilmente”, de lo contrario el impacto en los derechos, especialmente la libertad de expresión, se aumenta y amplifica negativamente.

*Publicado en El Espectador el 19 de marzo de 2021 https://www.elespectador.com/opinion/moderar-la-realidad/